알리바바 클라우드가 자사 큐원(Qwen) 시리즈의 통합 엔드투엔드 멀티모달 모델 'Qwen2.5-Omni-7B'를 공개했다.

이 모델은 텍스트, 이미지, 음성, 영상 등 다양한 형태의 입력 정보를 처리하고 실시간 텍스트 및 자연스러운 음성 응답을 지원한다. 특히 모바일 기기와 노트북과 같은 엣지 디바이스에 최적화된 멀티모달 AI 기술이다.

Qwen2.5-Omni-7B는 7B(70억) 파라미터의 컴팩트한 설계에도 성능 저하 없이 멀티모달 처리 능력을 제공한다. 이 모델은 시각 장애인을 위한 실시간 음성 설명, 동영상 속 재료를 분석한 요리 가이드 제공, 지능형 고객 응대 시스템 등에 활용 가능하다.

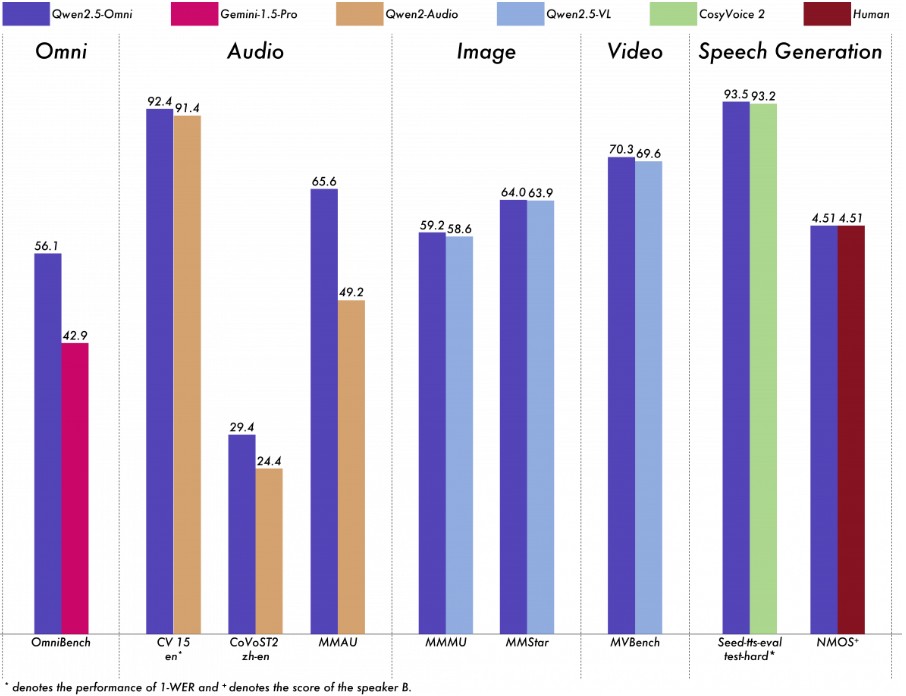

Qwen2.5-Omni-7B는 모든 모달리티에서 뛰어난 성능을 발휘하며, 유사한 규모의 단일 모달리티 특화 모델과 비교해도 경쟁력이 있다. 특히 실시간 음성 상호작용, 자연스러운 음성 생성, 엔드투엔드 음성 명령어 이행 등에서 업계 최고 수준의 벤치마크를 기록했다.

이 모델의 효율성과 고성능은 혁신적인 아키텍처에서 비롯된다. 텍스트 생성(Thinker)과 음성 합성(Talker)을 분리하는 'Thinker-Talker 아키텍처', 비디오 입력과 오디오를 동기화하는 위치 임베딩 기술 TMRoPE, 저지연 오디오 응답을 가능하게 하는 블록와이즈 스트리밍 처리 등이 적용되었다.

Qwen2.5-Omni-7B는 이미지-텍스트, 영상-텍스트, 영상-음성, 음성-텍스트, 텍스트 데이터를 포함한 방대하고 다양한 데이터셋을 기반으로 사전 학습되었다.

이 모델은 음성 명령을 정확히 이해하고 수행하는 데 뛰어난 성능을 보이며, 텍스트 입력만 사용하는 경우와 유사한 수준의 성능을 달성했다. 특히 OmniBench 벤치마크와 같이 다양한 모달리티를 통합적으로 처리해야 하는 작업에서도 최고 수준의 성능을 기록했다.

인컨텍스트 러닝을 통해 상황과 맥락에 따른 음성 이해 및 생성 능력을 향상시켰으며, 강화학습 기반 최적화를 통해 생성 안정성에서 상당한 향상을 보였다.

한편, 알리바바 클라우드는 지난해 9월 Qwen2.5를 처음 공개한 데 이어, 올해 1월에는 'Qwen2.5-Max'를 출시해 Chatbot Arena에서 7위를 기록했다. 또한 시각 이해와 장문 입력 처리를 위한 모델인 'Qwen2.5-VL'과 'Qwen2.5-1M' 등을 오픈소스로 공개했다.

글 : 허민혜(min3hui4@platum.kr)

ⓒ '스타트업 전문 미디어 & 중화권 전문 네트워크' 플래텀, 조건부 전재 및 재배포 허용