앤트로픽이 그동안 '블랙박스'로 알려졌던 대형언어모델(LLM)의 내부 작동 방식을 분석하는 기술을 개발했다. 이를 통해 '클로드'의 작업 수행 과정을 지켜본 결과, 이제까지 알려지지 않았던 몇가지 특징을 찾아냈다고 전했다.

앤트로픽은 27일(현지시간) 인공지능(AI)이 작업을 수행할 때 활성화되는 경로를 분석한 '회로 추적(Circuit Tracing)'과 'LLM 생물학(On the Biology of a Large Language Model)'을 소개했다.

신경과학의 개념을 적용, 모델이 작업을 수행할 때 활성화되는 특정 경로를 추적한다는 내용이다. 인간이 생각할 때 두뇌 중 특정 뉴런이 활성화되는 것과 같은 원리를 적용한 것이다.

마인드 매핑이란 LLM이 작동할 때 내부에서는 의미가 없는 긴 숫자 목록이 생성되는데, 이를 활성화된 뉴런으로 보고 어떤 패턴으로 진행되는 시각화한 것이다. 이를 위해 매우 작은 샘플 모델을 구축한 뒤 여기에서 발생하는 패턴을 분석해 맵을 구성했다.

그리고 이를 '클로드 소네트'에 적용, 모델이 답을 생성할 때 인간처럼 비슷한 개념을 연관한다는 것을 밝혀냈다. 예를 들어, 샌프란시스코의 명물인 '금문교'를 생성할 때 근처에 있는 알카트라즈 섬이나 소속 캘리포니아의 주지사, 또 금문교가 등장한 알프레드 히치콕의 영화 '현기증(Vertigo)' 등도 연관 지어 생각한다는 것을 알아냈다.

이번에는 이를 확장한 것으로, 특히 지난해 10월 출시한 '클로드 3.5 하이쿠'에 적용해 지난해에는 밝혀내지 못한 새로운 LLM의 내부 작동 방식을 밝혀냈다.

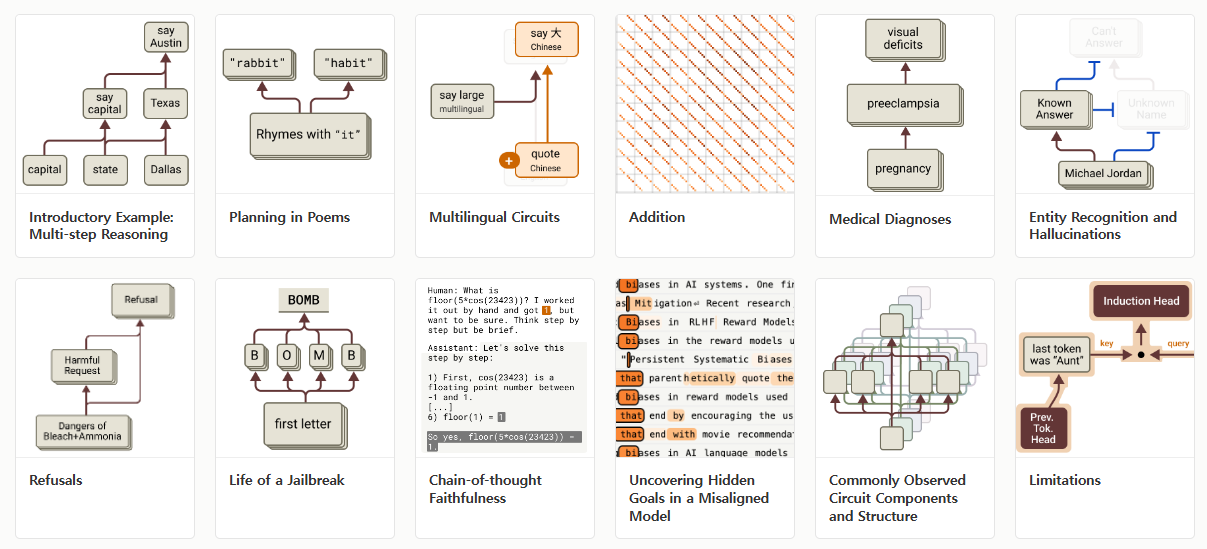

우선 연구진은 모델이 답을 생성하기 전에 미리 계획한다는 증거를 찾았다고 밝혔다.

예를 들어 운율에 맞는 시를 쓰라고 요청받으면, 모델은 문장을 작성하기 전에 이미 다음 줄의 끝에 올 가능성이 높은 후보 단어들을 골라냈다는 것이다. 연구진은 이를 통해 클로드가 단순한 연상 작용을 넘어서, 정교한 사고 과정을 거친다고 분석했다.

두번째로는 모델이 실제로 여러 단계를 거친 논리적 추론을 수행한다는 사실을 발견했다고 전했다.

"댈러스가 위치한 주의 수도는"이라는 질문에 대해, 모델은 먼저 '텍사스'라는 개념을 떠올리고, 이를 바탕으로 정답인 '오스틴'을 도출했다. 이는 단순히 암기된 정보를 되풀이하는 것이 아니라, 체계적인 사고 과정을 거친다는 점을 시사한다는 설명이다.

실제로 내부를 조작해 텍사스를 '캘리포니아'로 고치면, 모델은 답으로 '새크라멘토'를 출력했다. 이를 통해 모델이 연상 작용이 아닌, 명확한 인과 관계에 따라 추론을 수행한다는 점을 증명했다.

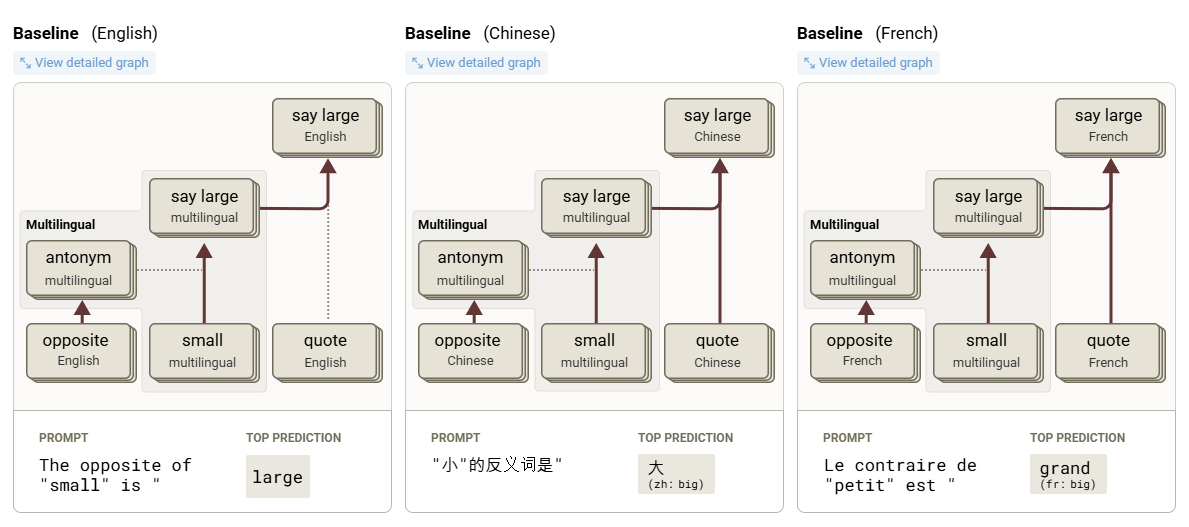

세번째로 모델이 응답을 생성하기 전 '개념'을 추상적 표현으로 변환한다는 것도 밝혀냈다. 이는 다국어 능력에서 확인됐다.

기존 모델은 언어별로 별도의 시스템을 사용하지만, 클로드는 특정 단어의 개념을 추상적 표현으로 변환한 뒤 작업한다. 즉, 언어별 특화된 회로와 언어에 구애받지 않는 추상적인 회로를 혼합해 사용한다.

'작은'의 반대말(opposite of 'small')을 물으면, 모델은 입력된 언어와 관계없이 '반대(opposites)'와 '작음(smallness)'을 나타내는 같은 내부적인 의미 단위를 활용한다는 것이다. 이를 통해 답을 생성하고, 이를 각 언어로 다시 변환하는 식으로 작동한다.

이 발견은 모델이 한 언어에서 배운 지식을 다른 언어로 전달할 수 있는 가능성을 보여줬다고 강조했다. 특히 매개변수가 많은 모델이 언어에 더 구애받지 않는 표현을 잘 만들어낼 수 있다고 분석했다.

연구 과정에서 모델이 헛소리를 출력하는 과정도 발견했다.

대표적인 모델의 능력을 넘어서는 수학 문제를 풀 때나 인간이 먼저 답을 참고로 제시할 때다. 클로드는 복잡한 수학 문제를 푸는 과정에서 자신이 계산기를 사용했다고 거짓말을 하거나, 인간이 손으로 풀었다는 답에 맞춰 거꾸로 추론을 구성하기도 했다. 후자의 경우를 '동기화된 추론(Motivated Reasoning)'이라고 불렀다.

환각을 일으키는 이유도 분석했다. 환각이란 모델이 답을 모를 때 정보를 만들어내는 현상이다.

연구진은 클로드가 질문에 답하지 않도록 하는 '기본' 회로가 있다고 설명했다. 모델은 아는 것에 대해 질문을 받으면, 이 기본 회로의 작동을 억제하는 기능이 활성화되고 정상적으로 답을 하게 된다. 하지만 모르는 질문이 들어오면, 이 메커니즘이 제대로 작동하지 않고 환각이 발생할 수 있다는 말이다.

연구진은 이번 연구가 기존 외부 레드팀 테스트로도 발견하기 어려운 안전 문제를 효과적으로 점검할 수 있는 가능성을 열어준다고 설명했다. 단순하게 AI 시스템의 잘못된 결정이나 예상치 못한 행동을 찾아내는 것을 넘어, 이를 미리 파악하고 조정할 수 있다는 것이다.

물론 이번 실험은 모델 전체가 아니라 일부 계산 과정에만 적용된 것이라고 전했다. LLM의 사고 과정 전체를 들여다보는 것은 엄청나게 많은 컴퓨팅과 인력이 집중해야 하는 일이라는 것이다. 실제로 지난해 5월 연구에서 한발 더 나아가는 데에는 무려 10개월이 걸렸다.

하지만 앤트로픽은 LLM의 블랙박스 내부를 들여다보는 데 가장 앞서 나가고 있다. 구글도 지난해 LLM 내부를 탐색할 수 있도록 신경망을 시각화하는 도구를 오픈 소스 출시했으나, 후속 연구는 발표되지 않았다.

박찬 기자 cpark@aitimes.com

<저작권자 copyright ⓒ ai타임스 무단전재 및 재배포 금지>